Hadoop - Introdução

Apache Hadoop é um quadro open source escrito em java que permite processamento distribuído de grandes conjuntos entre clusters de computadores usando simples modelos de programação. A Hadoop âmbito aplicação trabalha em um ambiente que fornece armazenamento distribuído e computação em clusters de computadores. Hadoop é projetado para aumentar a escala do único servidor com milhares de máquinas, cada uma delas oferecendo computação e o armazenamento local.

Hadoop Arquitetura

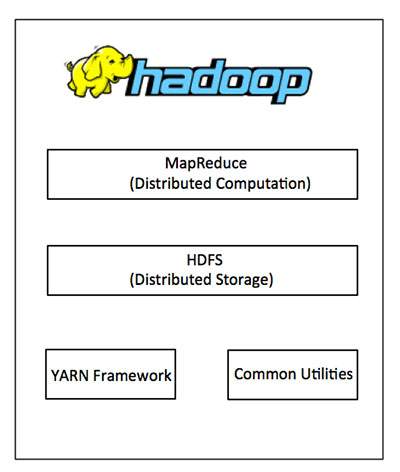

No seu núcleo, Hadoop tem dois grandes níveis:

- Cálculo/processamento camada (MapReduce), e

- Camada de armazenamento (Hadoop Distributed File System).

MapReduce

MapReduce é um modelo de programação paralela para escrever aplicações distribuídas elaborado no Google para processamento eficiente de grandes quantidades de dados (dados de vários terabytes de conjuntos), em grandes clusters (milhares de nós) de hardware de consumo confiável e tolerante a falhas. O programa é executado em MapReduce Hadoop que Apache é um open-source framework.

Hadoop Distributed File System

A Hadoop Distributed File System (HDFS) é baseado no Google File System (GFS) e fornece um sistema de arquivos distribuído que é projetado para ser executado em hardware de consumo. Ele tem muitas semelhanças com os sistemas de arquivos distribuídos. No entanto, as diferenças de outros sistemas de arquivos distribuídos são significativas. É altamente tolerante a falhas e é projetado para ser implantado em hardware de baixo custo. Ele oferece alta taxa de transferência acesso a dados de aplicativos e é adequada para aplicações de grandes conjuntos de dados.

Para além do acima-mencionados dois componentes principais, Hadoop framework inclui também as seguintes dois módulos:

Hadoop comum : Estas são as bibliotecas Java e utilitários necessários por outros Hadoop módulos.

Hadoop YARN : Este é um quadro de agendamento de tarefas e gestão recursos do cluster.

Como o Hadoop funciona?

É muito caro para construir servidores maiores com pesadas configurações que lidar com grandes transformações, mas como uma alternativa, você pode reunir muitos mercadoria computadores com uma única CPU, como um único sistema de distribuição funcional e prática, as máquinas em cluster pode ler o dataset em paralelo e proporcionar um maior rendimento. Além disso, é mais barato do que um servidor de alto desempenho. Portanto, este é o primeiro fator motivacional por trás usando Hadoop que corre em cluster e máquinas de baixo custo.

Hadoop executa um código em um cluster de computadores. Este processo inclui as seguintes tarefas fundamentais que Hadoop executa:

- Os dados são inicialmente dividido em diretórios e arquivos. Os arquivos são divididos em blocos de tamanho uniforme 128M e 64M (de preferência 128M).

- Em seguida, esses arquivos são distribuídos entre vários nós de cluster para processamento adicional.

- HDFS, sendo na parte superior do sistema de arquivos local, supervisiona o processamento.

- Os blocos são replicadas para lidar com falhas de hardware.

- Verificar se o código foi executado com sucesso.

- A espécie que ocorre entre o mapa e a reduzir as fases.

- Enviando os classificados os dados para um determinado computador.

- Por escrito, a depurar os logs para cada trabalho.

Vantagens do Hadoop

Hadoop framework permite que o usuário rapidamente escrever e testar sistemas distribuídos. É eficiente e automática, distribui os dados e trabalhar nas máquinas e, por sua vez, utiliza o paralelismo dos núcleos da CPU.

Hadoop não dependem do hardware para fault-tolerance e high availability (FTHA), bastante Hadoop biblioteca em si foi concebido para detectar e lidar com falhas na camada de aplicação.

Os servidores podem ser adicionados ou removidos do cluster dinâmico e Hadoop continua a funcionar sem interrupção.

Outra grande vantagem do Hadoop é que além de ser open source, é compatível com todas as plataformas já que é baseado em Java.